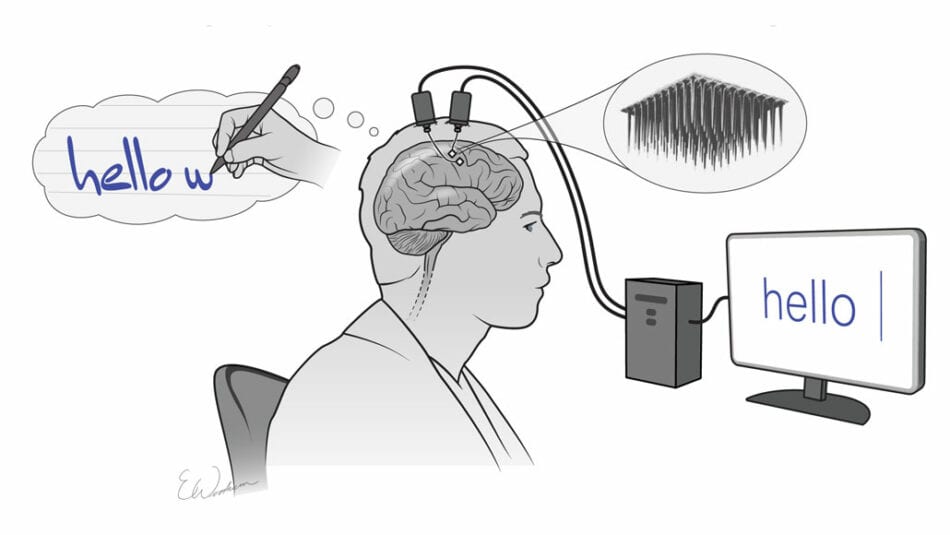

Mientras escribo estas líneas, la revista “Nature Comunications” publica el estudio clínico llevado a cabo por investigadores del Centro Wyss de Bioingeniería y Neuroingeniería, en colaboración con la Universidad de Tubinga (Alemania), con el que han conseguido que una persona de 30 años con parálisis completa, derivada de una esclerosis lateral amiotrófica (ELA) avanzada, se comunique gracias a la implantación de 64 microelectrodos en su corteza motora primaria y a una interfaz cerebro-ordenador (BCI). El paciente moduló las tasas de activación neuronal en función de la retroalimentación auditiva y usó esta estrategia para seleccionar letras una a una que le permitieron formar palabras y frases para comunicar sus necesidades y experiencias. Estos resultados dan esperanza a las personas que están completamente aisladas a causa de enfermedades neurodegenerativas progresivas para crear un canal de comunicación que les devuelva la facultad de expresarse.

Pero también, como manifiesta el equipo de investigadores que ha llevado a cabo el experimento clínico, éste avala las bases para avanzar en la decodificación del lenguaje directamente desde el cerebro de una persona durante el proceso de habla imaginada. Esto no solo permitiría tener una comunicación más fluida con pacientes que sufran un bloqueo total o síndrome de enclaustramiento completo (CLIS), una parálisis motora general empero con capacidades cognitivas y emocionales intactas, sino que además podría suponer el principio para poder acceder a otras funciones cerebrales más complejas como son el pensamiento, los sentimientos o la anticipación de la toma de decisiones.

Este tipo progresos tecnológicos realizados en centros científicos, públicos o privados, y bajo la premisa de ayudar a mejorar las condiciones de vida de pacientes con ciertos trastornos neurológicos que se traducen en discapacidades motoras o cognitivas, merecen todo el reconocimiento y el apoyo necesario para culminar con éxito el objetivo de integrar sistemas electrónicos en la red neuronal mediante BCIs que asuman el papel de las funciones o las regiones lesionadas o deterioradas. Que una persona con ELA pueda comunicarse, un paciente con Parkinson pueda controlar los episodios de temblores y la disfunción de sus movimientos o un parapléjico pueda volver a caminar, son algunos de los ejemplos que han sido fruto del interés científico por cumplir con sus principios deontológicos de combatir la enfermedad, procurar el bien del paciente, evitar dañar y actuar con generosidad aún a riesgo de su vida o de sus intereses personales.

Pero ¿qué puede suceder cuando esta tecnología no se desarrolla en el ámbito sanitario sino en el de empresas privadas con socios que exigen reparto de beneficios cada ejercicio? Tomemos como ejemplo Neuralink, la compañía de Elon Musk creada para desarrollar BCIs que conecten nuestros cerebros a sistemas inteligentes para, en principio, ayudar a personas con discapacidad para que puedan recuperar algunas de las habilidades o funciones perdidas a través del control mental de ordenadores y dispositivos móviles. La aspiración de conectar la inteligencia biológica con la artificial, de lograrse satisfactoriamente, permitirá no solo restaurar disfunciones motrices y sensoriales, sino que será el paso para expandir nuestras capacidades cognitivas y aventurar un nuevo mundo de múltiples interacciones interpersonales (brainet) y persona-máquina, y de oportunidades para mejorar la raza humana. Estos avances, a cargo de una empresa privada que deba responder a las compañías y fondos de inversión que aportaron el capital privado para llevarlos a cabo, ¿tendrían que ser vigilados para no caer en el riesgo de servir para otros propósitos más allá de los sanitarios?

Avances tecnológicos como por ejemplo los teléfonos inteligentes, las redes sociales o las plataformas de comercio electrónico, han pasado de ser instrumentos para comunicarse o hacer más fácil la vida de sus usuarios a ser fuente inagotable de datos para que grandes corporaciones puedan predecir y condicionar la conducta de miles de millones de personas. De manera análoga, neurocientíficos de todo el mundo ya han advertido de la posibilidad de que, en un plazo de dos décadas, los desarrollos descritos en los párrafos precedentes puedan convertirse en sistemas inteligentes para poder manipular los circuitos cerebrales, por lo que gobiernos y juristas deberían empezar a pensar en la legislación básica que proteja a los ciudadanos de esos avances enmascarados en soluciones médicas.

No se trata de obtener datos e información de comportamiento de compra, de preferencias, de respuestas emocionales o de tendencias ideológicas, sino de acceder a la identidad personal más íntima, que es la integridad psicológica, el pensamiento y la conciencia. Si contamos con una legislación sobre protección de datos personales, habrá que avanzar en los derechos de las personas para que, por un lado, no se pueda manipular su “yo” cuando se le implanten electrodos con cualquier finalidad médica ni queden registros de su actividad cerebral para monitorizar cómo se organizan las respuestas neuronales frente a estímulos externos e internos. E igualmente, no se debería aplicar esa tecnología para mejorar substancialmente las capacidades cognitivas de personas sanas para crear diferentes clases de humanos.

Aunque hay neurocientíficos, como M. Nicolelis, pioneros en la codificación de poblaciones neuronales , BCI y neuroprótesis, que también son defensores de la imposibilidad de poder acceder a los complejos e intrincados mecanismos que son ejecutados por grupos de cientos de millones de neuronas, de miles de millones de interconexiones entre ellas y de millones de células gliales encargadas de darles soporte y también de realizar algunas funciones conectoras, ya que los procesos que regulan no son codificados por estructuras estáticas sino enormemente variables. Esta propiedad, denominada plasticidad, eleva a un número tan extremadamente alto de posibles combinaciones de conexiones que supera a las que pueda realizar cualquier máquina actual, y con un consumo de energía que no llega al que tiene una bombilla de 20 vatios.

No obstante existan estas cautelas, recordemos el conocido dilema de Collingridge: siempre que nos enfrentamos a la implantación de un nuevo avance tecnológico, no somos capaces de evaluar las consecuencias sociales que puede llegar a tener; y cuando detectamos posibles efectos negativos, su uso está tan arraigado que es complejo controlarlo o impedirlo. Es decir, nadie elucubró que un teléfono móvil pudiera convertirse en un dispositivo que generase tal adicción en su uso, que las redes sociales pudieran servir de fuente de datos para personalizar ofertas comerciales y argumentos ideológicos, que la biometría como método para securizar operaciones garantizando la identidad del usuario se transformara en mecanismo de control ciudadano, etc.

Frente a este dilema, está quien contrapone el principio de precaución, ampliamente aplicado en el derecho internacional medioambiental, que (extrapolándolo) defiende que hasta que no se demuestre fehacientemente que ciertos avances tecnológicos no causan perjuicio alguno a individuos o colectivos, debe limitarse o prohibirse su aplicación. Llegar a ese extremo, seguramente limitaría la capacidad innovadora de muchos desarrolladores, por lo que los defensores del desarrollismo tecnológico pedirían un período de carencia para legislar mientras se encuentra una prueba de seguridad consistente o evidencia irrefutable de perjuicio.

Realmente es una situación compleja de afrontar, aunque la experiencia corrobora que las leyes han ido siempre detrás de las innovaciones y tendencias sociales, culturales, tecnológicas, etc. Sin embargo, en el ámbito de la neurociencia, por ejemplo, no se debería esperar a evidenciar malas praxis para proteger el derecho de los ciudadanos a decidir el acceso a su “intimidad cognitiva”, con independencia de que acepten el implante de “neurochips” para cuestiones médicas. Abordar la protección de esos derechos no es solo una cuestión jurídica, sino también ética que debe afrontarse con urgencia. En España, algo se ha avanzado en el apartado XXIV de la Carta de Derechos Digitales redactada el año pasado tomando como base las propuestas de la plataforma Neuro Right Initiative, en la que se ha recogido (I) el derecho a la privacidad mental para garantizar que la actividad del cerebro no sea descifrada sin consentimiento expreso, (II) el derecho a la identidad psicológica para evitar que la personalidad sea manipulada, (III) el derecho al libre albedrío para no influir en los procesos de toma de decisiones, (IV) derecho a la igualdad de oportunidades para evitar le mejora cognitiva de determinadas personas en detrimento de otras, y (V) el derecho a ser consciente de los efectos que puede tener la implantación de neurotecnologías y la aplicación de programas o algoritmos que pudieran llevar incorporados sesgos cognitivos.

Siendo estos principios bienvenidos para, al menos, definir el marco legal sobre el que trabajar, dado que la neurociencia lleva más de tres lustros investigando soluciones tecnológicas para, con métodos invasivos o no invasivos, encontrar soluciones a problemas neurodegenerativos o importantes lesiones, lo que ya es apremiante es la regulación jurídica y ética con naturaleza de ley que bloquee las pretensiones de cualquier empresa de aprovechar la neurotecnología para obtener beneficios a partir de la explotación de información inherente a la actividad cerebral de los pacientes. En primera instancia, porque no olvidemos el futurible de conectar a personas con máquinas para elevar sus capacidades intelectuales, motoras o sensoriales. En segundo lugar, habrá que prever igualmente cómo prevenir el uso de tecnologías no invasivas que puedan extraer esa información de manera coercitiva o no consentida, que puedan ejercer el llamado neurohacking o la manipulación de la percepción o de la memoria.

Tranquiliza saber que, además del gobierno de España, la OCDE lanzó en 2019 una recomendación sobre innovación responsable en neurotecnología, que el Consejo de Europa ha creado el Plan de Acción Estratégica centrado en derechos humanos y nuevas tecnologías biomédicas y que la ONU pretende promover en 2023 una modificación de la Declaración de los Derechos Humanos que recoja estas inquietudes. No obstante, es necesario promover también la ampliación del juramento hipocrático que realizan los médicos a los científicos especializados en neurotecnologia, para asegurar la finalidad de los ensayos clínicos bajo el paraguas de unos principios deontológicos comunes que limiten el espacio de investigación de lo que será la cuarta revolución industrial (4.0), en la que convergirán tecnologías digitales, físicas y neurobiológicas.

Legislación, normativa ética, compromiso científico, voluntad política y conciencia social serán las claves para que los derechos de los ciudadanos, en materia de protección de la información de su actividad neuronal, no sean vulnerados, y para que los desarrollos tecnológicos no se vean abocados a cumplir el principio de Skolnikoff, es decir, que terminen siendo utilizados para otros propósitos diferentes para los que originalmente fueron creados.

José Manuel Navarro Llena

CMO MOMO Group

Articulo publicado en ITUser, nº 77, páginas 144-148

Descarga artículo: it-user-77_Neuroderechos

Deja una respuesta